La voiture autonome et ses implications morales

Chapitre 2. L’évolution industrielle face à l’éthique.

Section 1. La voiture autonome et ses implications morales, un débat resté sans réponse.

La question des choix éthiques imposés à l’algorithme est tout aussi problématique.

§1. Un débat fragile.

En cas d’accident de la route imminent, quelles décisions les véhicules entièrement automatisés seront-ils à terme capables de prendre ?

Quelles répercussions auront-elles sur le sort des victimes ?

Il est évident que ce n’est pas la voiture directement qui sera confrontée à un tel choix, mais les opérateurs qui auront programmé les algorithmes la composant.

Ce seront ces algorithmes prédéfinis qui détermineront son comportement en faveur d’un choix plutôt qu’un autre.

Cependant, plusieurs questions se posent:

* Qui dispose d’une telle légitimité ? Le programmateur informatique ?

Le législateur ? Le constructeur de l’automobile ? L’acheteur ?

* Quels seraient les critères de décision et comment les justifier ? En effet, comment les véhicules feront-ils pour prendre la décision que nous jugerions la plus « juste » possible ?

Autant de questions qui pour le moment restent sans réponse mais qui devront être réglées avant qu’une commercialisation soit envisageable…

D’autant plus que ces algorithmes devront respecter trois attentes potentiellement incompatibles:

- être cohérent,

- ne pas provoquer l’indignation publique, et

- ne pas décourager les acheteurs.

Un début de réponse pourrait être donné si dans un premier temps les constructeurs automobiles témoignaient d’une transparence absolue sur le comportement de leur véhicule.

Mercedes-Benz a affirmé sa position l’année dernière en déclarant que « si vous savez que pouvez sauver au moins une personne, sauvez au moins celle-là. Sauvez celle qui est dans la voiture (…).

Mais il n’est pas sûr que tous partagent le même point de vue, et c’est là tout le problème…

§2. Etudes sociologiques: « un de perdu dix de sauvés » ?

A) Etude du MIT.

Jean-François Bonnefon, directeur de recherches au CNRS et une équipe de chercheurs franco-américaine de l’université de l’Oregon et du MIT, ont publié une étude à ce sujet, le 23 juin 2016, dans la revue Science87.

2000 personnes ont été interrogées sur cette question morale et exposées à plusieurs scénarios possibles à l’aide de la réalité virtuelle.

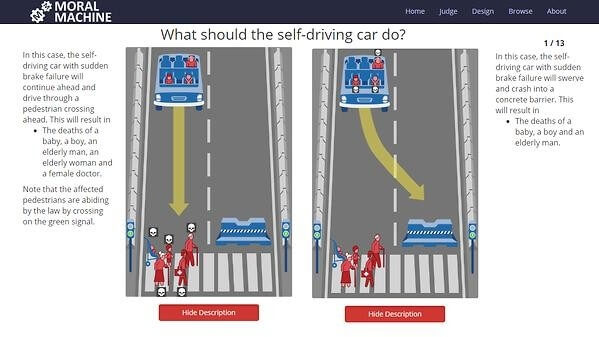

Annexe 8: Interrogations et résultats d’un test du MIT relatif à l’éthique des voitures autonomes (réalisé par un tiers).

Le test du MIT88 a permis d’évaluer la tendance des choix moraux retenus en cas d’accident impliquant un véhicule autonome.

88 Test Moral Machine – Massassuchetts Institute of Technology: http://moralmachine.mit.edu/

Ce dilemme philosophique, rappelant celui du trolley ou encore celui de la passerelle, est censé positionner les gens entre éthiques utilitariste (la fin justifie les moyens) et déontologique (ce choix est immoral par principe).

En l’espèce, une voiture autonome rencontre un problème technique et ne peut pas manifestement pas freiner. A son bord, un enfant, une personne âgée, un homme. Cinq piétons traversent au feu vert.

Faut-il préférer donner un coup de volant pour éviter les piétons en sachant que cette décision pourrait « sacrifier » les usagers à bord du véhicule ou poursuivre sa route et percuter les piétons afin de protéger l’intégrité des usagers du véhicule ?

En serait- il de même si les conditions étaient différentes, par exemple si les piétons traversaient au feu rouge ? Ou alors si ceux-ci étaient des enfants ?

Différentes situations sont envisagées.

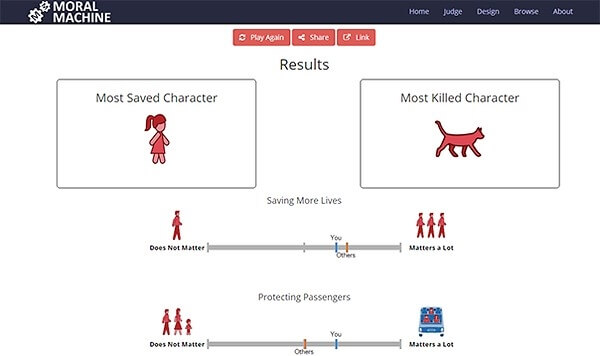

Annexe 9: Interrogations et résultats d’un test du MIT relatif à l’éthique des voitures autonomes (réalisé par un tiers).

Selon les résultats recensés lors du test proposé par le MIT, la plupart des gens tendent à privilégier le plus grand nombre de vies sauvées (la logique utilitariste donc), et pour 80% d’entre eux à favoriser les humains.

Il ne semble pas y avoir de préférence entre les passagers de la voiture et les piétons en face.

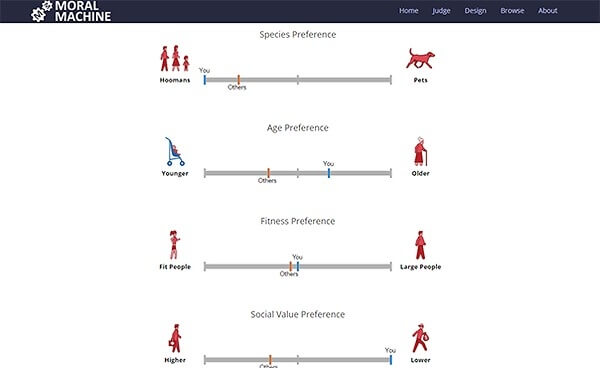

Annexe 10: Interrogations et résultats d’un test du MIT relatif à l’éthique des voitures autonomes (réalisé par un tiers).

87 Bonnefon J-F., Shariff A., Rahwan I. Autonomous Vehicles need experimental ethics: are we ready for utilitarian cars ?, 12 oct. 2015: https://arxiv.org/pdf/1510.03346v1.pdf

Une majorité de répondants tend à sauver le plus souvent les enfants plutôt que des personnes âgées, et à prendre en compte la “position sociale” de la personne en face (épargner un médecin plutôt qu’un individu s’apparentant à un bandit par exemple).

A l’instar du dilemme du trolley, le critère de la morphologie physique a été ajouté, et il semblerait que les résultats soient légèrement supérieurs à 50% lorsqu’il est question d’agir en faveur d’une personne « mince » plutôt que bien portante.

Ces résultats ne font pas office de solution, mais fournissent une première réaction publique à l’instauration des voitures autonomes. Il est certain que les travaux ultérieurs devront apporter des normes sociales bien définies. Mais…

Lesquelles ?

Peut-on réellement envisager que la solution soit différente en fonction des passagers à bord ou des usagers de la route ?

Aussi, les fabricants automobiles pourront-ils créer différentes versions d’algorithmes moraux ?

Quid de la responsabilité de celui qui a choisi/acheté un algorithme qui prend des décisions néfastes ?

B) Etude du laboratoire Ethics.

Des chercheurs du laboratoire Ethics à l’Université catholique de Lille, lors d’un colloque tenu les 13 et 14 mars 2017 ont cherché à illustrer les enjeux éthiques au cœur des progrès technologiques du XXIe siècle.

Comment les jugements éthiques sont influencés par le contexte dans lequel la décision est prise ? (là aussi, des situations différentes selon le nombre de piétons et le type de la population piétonne: enfants, personnes âgées, femmes enceintes, piétons qui traversaient au feu rouge, voleurs, etc.).

Décide-t-on différemment selon qu’on est occupant de la voiture ou législateur ?

Les résultats de cette enquête répondent par la positive, et montrent une divergence profonde entre les réponses données par les occupants de la voiture et celles données par les personnes occupant le rôle du législateur.

Les dernières décident majoritairement de sacrifier l’occupant de la voiture pour sauver plus de vies, alors que les premiers ne sont quasiment jamais prêts à se sacrifier pour les autres.

Là aussi, les réponses dépendent de la population qui traversait la rue: les enfants sont le plus souvent sauvés aux dépens de l’occupant de la voiture, alors que les personnes âgées et les piétons qui traversent au feu rouge sont le plus souvent sacrifiés, même par le législateur.

Ces deux études démontrent que la majorité des sondés pensent que l’algorithme devra être conçu dans une logique utilitariste et donc sacrifier son conducteur pour sauver plusieurs personnes. Ce qui semble acceptable moralement et conforme aux attentes en matière de sécurité.

Pour autant, un dilemme social se dessine: les mêmes personnes estiment que si elles avaient le choix, elles n’achèteraient pas de véhicules intelligents susceptibles de les sacrifier.

Comment ne pas trouver ceci légitime ? En effet, comment concevoir que son propre véhicule pourra, s’il y avait lieu de décider, mettre sa propre vie en danger et sacrifier89 celle-ci au profit d’étrangers ?

89 Lin P. The robot car of tomorrow may just be programmed to hit you, 05 juin 2014: https://www.wired.com/2014/05/the-robot-car-of-tomorrow-might-just-be-programmed-to-hit-you/

Selon l’étude du MIT, trois groupes peuvent être en mesure de décider comment gérer les dilemmes éthiques des voitures autonomes:

- Les consommateurs qui les achètent,

- Les fabricants qui les programment

- Le gouvernement qui peut réguler le type d’algorithmes que les fabricants peuvent proposer et que les consommateurs peuvent choisir.

Il faudra donc trouver une solution qui n’est pas certaine de convenir à tout le monde…

Section 2. Quelle solution éthiquement acceptable ?

La conception de véhicules autonomes appelle une autre question:

La technologie va-t-elle améliorer les capacités humaines en termes de conduite (comme un continuateur de la personne humaine), ou va-t-elle simplement la remplacer ?

Dans cette deuxième hypothèse, que faut-il attendre (de plus ou de moins) de la machine ?

Dans un article intitulé la voiture autonome et ses implications morales90, Anders Sandberg et Heather Bradshaw-Martin, deux chercheurs anglais, sans toutefois apporter les solutions à ces questions ont cherché à en définir les contours.

Selon eux, il existe plusieurs points de vue possibles qu’il est intéressant d’aborder dans cette étude:

Le premier raisonnement serait de ne pas attendre davantage du véhicule que ce que nous attendrions d’un conducteur humain, avec toutes les limites et imperfectibilités qu’on lui connaît.

90 Sandberg A. et Bradshaw-Martin H. La voiture autonome et ses implications morales, Traduit de l’anglais par Mona Gérardin-Laverge, 2015.

Par exemple, si au moment d’un accident imminent le véhicule autonome prend la décision d’éviter un obstacle sur sa chaussée et percute accidentellement deux jeunes cyclistes se trouvant sur la fil d’à côté, alors pourquoi ne pas accepter un tel choix ?

Un conducteur humain en pareille situation aurait-il fait différemment ? Nul ne le sait tant qu’il ne s’y retrouve pas confronté.

De plus, selon quoi est-on influencer lorsque l’on pense qu’il s’agit de la « meilleure » solution ?

Le conducteur humain se serait certainement laissé influencer par son instinct de survie, ses réflexes, sans pour autant vouloir dire que cela était le choix le plus moral pour lui. Il pourrait également agir en fonction de convictions morales personnelles.

Mais le fonctionnement de la société suppose que les humains peuvent ne pas partager les mêmes convictions morales.

Il est donc dur de pouvoir juger de ce qui serait le plus acceptable moralement… Aucun standard « moral » ne pourrait être proposé puisqu’il n’y aurait certainement pas de consensus sur le sujet.

Qui plus est, il n’y a pas que le conducteur humain qui est susceptible d’agir en fonction de considérations morales. Même les ingénieurs qui seront en charge de programmer l’intelligence artificielle devront admettre qu’ils ont choisi la théorie en laquelle ils croyaient le plus mais quel droit ont-ils d’imposer leur croyance aux consommateurs potentiels qui pourraient tenir aussi fortement à l’autre théorie ?

Les auteurs de cet article soulignent toutefois que l’argument de « l’urgence » ne vaut pas pour les programmeurs du véhicule qui travaillent au quotidien sur l’issue à donner à chaque scénario rencontré.

C’est donc plus rationnellement que leurs choix sont examinés et jugés, c’est pourquoi ils devront être en mesure de pouvoir les justifier.

Une autre solution est envisageable selon ces chercheurs: fixer un niveau d’exigence global sur les réactions de l’intelligence artificielle en situation réelle – qu’il soit plus élevé ou plus bas – que ce que nous attendons d’un individu humain.

Mais est-ce réellement plausible ?

Les humains et les véhicules autonomes ont des capacités très différentes.

Alors que l’humain réagit par instinct et bien souvent par habitude (quelles soient bonnes ou mauvaises…) la machine réagira en fonction d’un comportement standard, tel l’ancien bon ère de famille en droit civil, qu’on lui aura appris.

Peut-être que la décision de la machine sera plus sage, mais moins sensée (elle agira sans comprendre toutes les implications morales que cela induira).

Qui plus est, ce parallèle est biaisé car le mécanisme intrinsèque de la voiture automatisée a été conçu pour réagir plus rapidement qu’un humain, il est donc difficile de pouvoir fixer des exigences pour l’un en référence aux exigences fixées pour l’autre.

Une troisième possibilité partagée par plusieurs auteurs de la doctrine serait d’exiger que l’acheteur du véhicule choisisse au moment de la programmation de l’algorithme ce qu’il voudrait que le véhicule fasse dans une multitude de scénarios différents.

Dès lors, plus de problème de responsabilité car si le véhicule agit conformément au choix de l’usager, les fabricants et programmeurs s’en trouvent déresponsabilisés.

Cette solution pourrait être celle de la facilité, cependant il est certain que cela ne règlerait pas pour autant les questions éthiques car où seraient les limites ?

La sécurité promise par les industriels pourrait être remise en cause si les voitures autonomes n’étaient pas conçues de la même façon, si chaque utilisateur pouvait « commander » une voiture plutôt qu’une autre…

Comme l’ont démontré les études réalisées, deux comportements sont possibles:

* La première ligne de conduite suit la théorie utilitariste ou conséquentialiste qui soutient que moins il n’y a de mort, mieux c’est; c’est-à-dire que la voiture analysera la situation et réagira instantanément en choisissant le scénario qui sauvera le plus de vie possible.

* L’autre théorie déontologique, plus proche de la pensée kantienne, soutient que ce qui compte moralement, c’est l’intention qui est derrière l’action et non les résultats.

Il est donc moralement inacceptable d’entreprendre une action délibérée dont le résultat intentionnel est une mort certaine. Autrement dit, ne pas agir est préférable même si cela provoque deux morts plutôt qu’une, parce que ce n’est pas une action délibérée.

La solution s’explique selon les chercheurs en ce qu’elle serait le résultat de réactions émotionnelles immédiates, alors que la thèse conséquentialiste proviendrait d’une démarche intellectuelle plus poussée.

Pour le moment, aucune théorie plutôt que l’autre n’a été retenue.

Conclusion:

Si leur déploiement est bien encadré, les véhicules connectés et autonomes devraient révolutionner la mobilité et contribuer, entre autres, à une réduction importante de la mortalité routière.

L’industrie automobile espère pouvoir commercialiser les premiers véhicules à délégation partielle de conduite à l’horizon 2020, et ceux à délégation totale d’ici 2025-2030.

Pour y parvenir, les obstacles sont encore nombreux que ce soit sur les plans humain, technologique, réglementaire ou juridique.

En effet, au-delà des nouveaux défis qu’ils posent, les véhicules connectés et autonomes génèrent de nouvelles problématiques de société liées à l’innovation technologique.

D’un point de vue réglementaire, il est clair que la France accuse un certain retard par rapport à ses voisins étrangers, notamment les Etats-Unis. La raison à cela: la disparition progressive du rôle du conducteur pourtant cher à la Convention de Vienne sur la circulation routière du 8 novembre 1968.

Par conséquent, les régimes de responsabilités et d’indemnisation (consacré par la loi Badinter du 5 juillet 1985) ne sont pas assez adaptés à l’arrivée des voitures autonomes et devront faire l’objet en tout ou partie d’une refonte.

D’une part, il sera souvent impossible pour la victime de relier les dommages causés en cas d’accident de la circulation à une quelconque faute humaine, ce en raison de l’autonomie fonctionnelle du système embarqué (mu par une multitude d’algorithmes et un procédé d’apprentissage appelé le machine learning) et d’un conducteur relégué au statut de passager.

C’est pourquoi il semblerait que le régime de responsabilité sans faute soit requis.

D’autre part, les régimes de responsabilité du fait des choses et des produits défectueux, qui sont des régimes de responsabilité sans faute, ont été pensés dans une perspective purement matérielle, corporelle (la preuve en est avec les concepts de garde de l’article 1384 ancien du Code civil, ou de dessaisissement de l’article 1386-5 du même Code).

C’est pourquoi, même si l’on parvenait à les appliquer à la voiture autonome e en étendant encore une fois leur champ d’application, ils conduiront certainement à des solutions inopportunes et déséquilibrées.

Soit parce qu’ils prévoiront une responsabilité trop automatique, soit parce qu’ils organiseront une distribution injuste des responsabilités.

Les solutions apportées dans ce développement ne promettent pas de résoudre ce schéma complexe, mais peuvent constituer des pistes de réflexion.

En effet, la création d’un régime hybride répartissant la responsabilité d’un dommage entre plusieurs débiteurs permettrait un système plus juste pour chacun:

- autant pour les victimes pour qui l’indemnisation serait facilitée

- pour le propriétaire utilisateur du véhicule pour qui il serait injuste de se voir imputer l’entière responsabilité, surtout en cas de dysfonctionnement du système embarqué (et de facto, pour son assureur)

- que pour les constructeurs automobiles qui, en fonction de la cause de la défaillance ayant engendré le dommage pourront éventuellement s’exonérer (notamment en cas de risque de développement) pour que soit imputée la responsabilité des concepteurs de l’intelligence artificielle.

Force est de constater que le schéma assurantiel devra, lui aussi, être adapté pour coïncider avec les enjeux de la voiture sans conducteur.

Mais pour cela, les mutuelles et compagnies d’assurance spécialisées dans l’assurance automobile pourront compter sur l’assurance de tous nouveaux risques, notamment la protection des données personnelles de l’assuré contre les risques de cyber attaque.

Enfin, la voiture autonome posera également bon nombre de questions d’un point de vue éthique: entre théorie utilitariste/conséquentialiste et déontologique.

Le compromis sera certainement dur à trouver puisqu’il faut le rappeler, la promesse des concepteurs automobiles pour ce produit est l’assurance d’une plus grande sécurité, donc qui opterait pour une voiture (à un prix encore très onéreux) qui serait susceptible de « choisir » de le sacrifier ?