L’intégration des données en temps réel est essentielle face à l’explosion des volumes d’informations. Cette étude révèle une approche innovante qui transforme l’architecture ETL traditionnelle, promettant une gestion efficace des données hétérogènes et des implications significatives pour les entreprises modernes.

Deuxième partie Contribution et Implémentation de

l’approche

Chapitre 4

Conception de l’approche

Introduction

Dans le chapitre précédent nous avons exposé notre problématique et nous l’avons positionnée par rapport aux travaux connexes.

Pour surmonter les limites des outils ETL classiques, tout en prenant en compte l’aspect flux des données émanant du Web, nous proposons dans ce chapitre notre contribution qui consiste en une nouvelle approche d’enrichissement des outils ETL pour l’intégration du données.

Nous commençons le chapitre par la présentation du principe général de fonctionnement de la solution proposée, puis on discutera l’architecture du système proposé. Après cela, la description du fonctionnement de la solution est abordée en détails, et enfin nous terminerons le chapitre par l’exposé d’un scénario qui illustre la faisabilité de notre approche par l’examen d’un scénario réel.

Principe de la solution proposée

Notre approche se base fondamentalement sur la prise en compte des flux de données distribuées et leur changement avec le temps. En effet, bien que les données se trouvant au niveau des différentes sources soient rapatriées et intégrées dans l’entrepôt de données, il s’avère que leur variation au niveau des sources soit instantanée. Cette variation des données est due aux changements opérés lors des différentes actions de mise à jours.

La conséquence immédiate est que les données contenues dans l’entrepot ne reflètent plus la réalité et, par conséquent, deviennent incompatibles.

Notre contribution pour remédier à cette limitation se situe au niveau des étapes d’extraction et de transformation des données aux quelles nous apporterons certaines améliorations afin de prendre en compte les données versatiles du Web et aussi pour améliorer les performances des systèmes ETL.

Dans cette perspective et pour permettre un rafraichissement continu des informations contenues dans l’EDD, nous considérons une nouvelle perception de la phase d’extraction qui constituera le noyau de notre contribution.

Le fondement de notre approche vise à améliorer les performances de la phase d’extraction de ces outils. Cet objectif est réalise sur la base de deux aspects complémentaires. Le premier consiste à adopter des stratégies pour la phase d’extraction visant à travailler avec des données versatiles et changeantes au fil du temps à partir du Web. Le deuxième est relatif à la spécification des règles de transformation à appliquer.

Nous décrivons, dans ce qui suit les principes fondateurs de notre solution baptisée :

OnLine Extract Selective Transform and Load (OLE-STL).

- Une extraction initiale est opérée à partir des différentes sources ;

- Au lieu d’appliquer l’ensemble des règles de transformations, telles que décrites dans la section 2.6.4 (b), dans notre approche nous classons ces règles en quatre catégories distinctes qui sont les suivants :

- format ;

- granularité ;

- codage ;

- pré-calcul.

L’utilisateur aura la possibilité d’appliquer de manière sélective une ou plusieurs règles lors du processus de transformation au lieu de les déclenches en totalité de manière séquentielle.

- Une fois, les règles de transformations choisies, les processus Transform et Load sont ensuite lancés afin d’alimenter l’EDD par les données converties.

- Si la structure de l’EDD a évolué et exige l’intégration de nouvelle sources, une extraction additive de la (les) source (s) en question est faite. Évidemment la transformation et le chargement de ces sources seront réalisés en conséquence ;

- Le point le plus intéressant dans notre approche consiste en un mécanisme de test d’existence de modifications au niveau des sources est activé pour identifier les sources qui ont été changées après le dernier chargement. Ce mécanisme repose sur la vérification et la comparaison des sources de données qui s’appuie sur les fichiers log ;

- Enfin, la phase d’enrichissement de l’EDD par un chargement (Load) de ces nouvelles données transformées est effectué.

Contribution majeures de la solution

La solution proposée est un système ETL amélioré nommée OLE − STL dont son mécanisme considère principalement la phase d’extraction (E) pour laquelle une transformation sélective est suggérée. Ainsi, notre contribution se situe à trois niveaux :

- Une technique de transformation sélective qui considère uniquement la (les) catégorie(s) de transformations choisies par la gestionnaire de données.

- Au niveau de l’étape Extract une option d’extraction additive est proposée en cas d’évolution du schéma de l’EDD.

- Un technique pour le test d’existence de mise à jour au niveau des sources, basée sur la comparaison des dates de mise à jour des fichiers sources avec la dernière date de chargement. Cette technique utilise des structures de données de type table pour suivre la traçabilité des modifications des sources.

Après avoir expliqué le principe général de notre solution, la prochaine section est dédiée à l’exposé de l’architecture de notre système (OLE-STL).

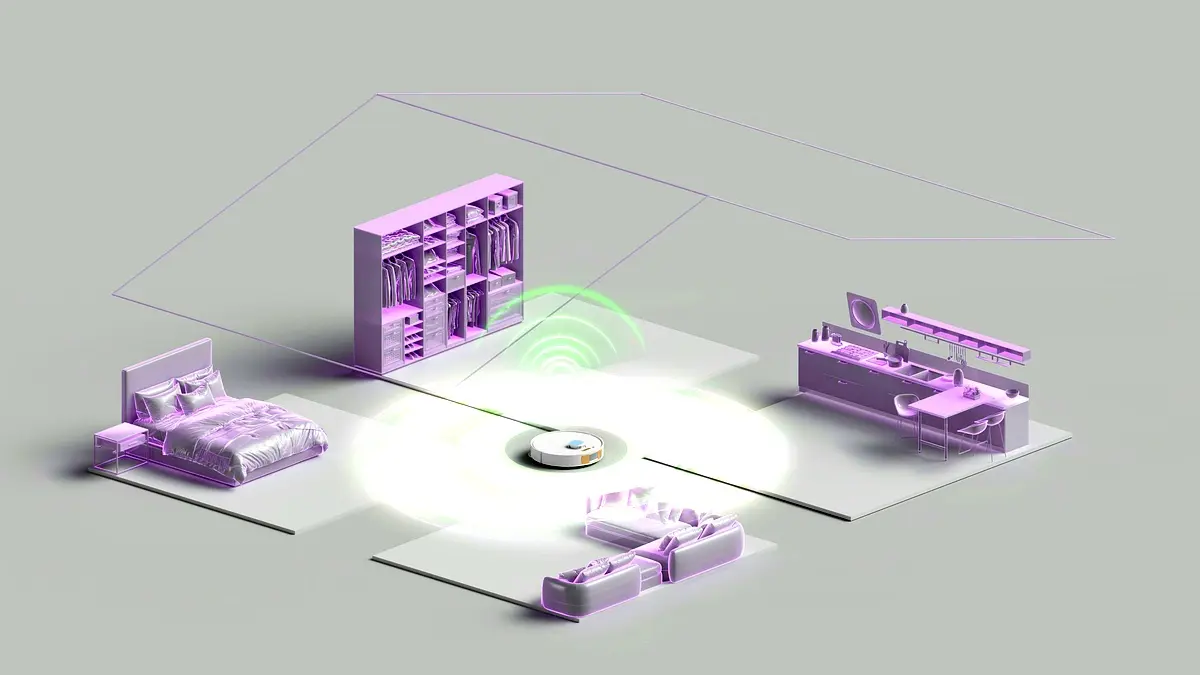

Architecture générale du système proposé

Pour faire face au problème de la diversité des données ,de leur vitesse d’évolution ainsi que leur volume qui est de plus en plus consistant, et comme nous avons expliqué dans notre problématique, les outils ETL restent limités pour le traitement de ces données qui se caractérisent par leur spontanéité c’est-à-dire les données en temps réel.

Notre système (OLE-STL) propose une solution axée essentiellement sur les deux premiers phases Extract et transform de l’ETL dans laquelle on a divisé le système en trois passe qui sont :

- Passe 1 : Elle se compose de trois étapes et commence par l’étape d’extraction initiale à partir de diverses sources suivie d’une transformation sélective qui permet aux utilisateurs de sélectionner une ou plusieurs règles parmi un ensemble de règles de transformation au cours de ce processus, et enfin il se termine par un chargement (Load) pour alimenter l’EDD. Cette passe est illustrée par la séquence 1-2-3 de la figure 4.1.

- Passe 2 : Elle est organisé en trois phases qui sont entamées avec l’extraction additive appliquée dans le cas ou la structure de l’EDD a évolué et nécessite l’intégration de nouvelles sources, puis les étapes de transformation et de chargement sont déclenchées pour enrichir l’EDD. Cette passe est illustrée par la séquence 1’-2-3 de la figure 4.1.

- Passe 3 : cette passe est différente des deux premières passes. Ainsi au cours de la phase d’extraction ou opère une extraction incrémentale qui permet d’identifier les sources qui ont été changées après le dernier chargement. Il s’agit d’une extraction fondée sur la vérification et la comparaison des sources de données, et par la suite le lancement des processus de transformation sélective et de chargement pour actualiser l’entrepôt. La comparaison est basée sur les tests de dates de mise à jour. Cette passe est illustrée par la séquence 1”-2-3 de la figure 4.1

En effet la figure 4.1, explique bien l’architecture de notre système (OLE-STL) et l’enchainement des trois passe ci dessus citées.

Questions Fréquemment Posées

Quelle est la nouvelle approche d’intégration des données proposée?

Notre approche se base fondamentalement sur la prise en compte des flux de données distribuées et leur changement avec le temps.

Comment l’approche OLE-STL améliore-t-elle les systèmes ETL traditionnels?

Cette approche vise à améliorer les performances de la phase d’extraction et à travailler avec des données versatiles et changeantes au fil du temps à partir du Web.

Quelles sont les catégories de règles de transformation dans l’approche proposée?

Nous classons ces règles en quatre catégories distinctes : format, granularité, codage et pré-calcul.

Comment le mécanisme de test d’existence de modifications fonctionne-t-il?

Ce mécanisme repose sur la vérification et la comparaison des sources de données qui s’appuie sur les fichiers log.