L’analyse des résultats YouTaQA révèle l’efficacité des modules du système de questions-réponses intelligent, en les comparant aux travaux antérieurs. Ce chapitre met en lumière les contributions significatives de YouTaQA à l’état de l’art dans le domaine de la recherche d’information et de l’apprentissage profond.

Chapitre 4 :

Analyse et discussion des résultats

Introduction

Durant ce dernier chapitre, nous présenterons les résultats de chaque module de notre système. La deuxième partie de ce chapitre consiste à présenter les résultats globaux de notre système YouTaQA ce qui nous permettra de positionner et de comparer ce dernier avec les travaux antérieurs et de mettre en évidence la valeur ajoutée que ce système apporte à l’état de l’art de ce domaine.

Prétraitement et fractionnement des données

Comme mentionné précédemment, le moteur de recherche et les modules de classification et d’extraction de réponses ont été entrainés et testé sur l’ensemble de données SQUAD. Le jeu de données « Train set » est divisé en 2 parties. La première partie représente 80% du total et est utilisée pour l’entrâınement des modèles de Deep Learning. Les 20% restantes représentent le « Validation set » qui est utilisé pour équilibrer le modèle et choisir les bons hyper-paramètres. Tans dis que le « Test set » est utilisé pour évaluer les différents modules du système et voir l’amélioration des résultats obtenus.

Résultats du module de recherche d’information MRI

Après avoir établi un premier prototype de notre système, nous l’avons testé en utilisant l’évaluateur TREC-Eval en nous appuyant sur le dataset SQuAD. Nous avons utilisé les questions présentes dans ce dernier en les considérant comme requêtes pour notre moteur de recherche et comparer ses résultats avec les passages fournis par SQuAD.

Méthodes de recherche employées

Nous avons lancé l’évaluateur TREC-Eval avec les 4 méthodes de recherche afin de comparer les performances de chaque méthode et choisir à la fin la meilleure méthode à utiliser. Ces méthodes seront décrites dans ce qui suit.

VSM SimpleSearch : Dans cette méthode de requêtage, nous avons utilisé le modèle de classement des résultats VSM (Voir la Section 2.1.1) tout en utilisant une recherche simple des mots clés de la requête dans le contenu des articles seulement.

VSM MultiFieldsSearch : Cette méthode de recherche est basée sur la recherche multi-champs (Multi-Fields Search en anglais), c’est-à-dire la recherche des mots d’une requête est effectuée non seulement sur le contenu de l’article mais aussi sur le titre de ce dernier.

BM25 SimpleSearch : La présente méthode est basée sur une simple recherche dans le contenu des articles. Durant l’étape de classement des résultats, ici nous utilisons l’approche BM25 au lieu du VSM (Voir la Section 2.1.1).

BM25 MultiFieldsSearch : Là, nous avons implémenté une méthode de recherche qui emploie la recherche multi-champs (recherche appliquée dans le contenu et le titre des articles au même temps). Là aussi, nous utilisons l’approche BM25.

Discussion des performances des méthodes de recherche

Après avoir lancé l’évaluation de toutes les méthodes, nous avons tracé des graphes et des histogrammes afin de comparer les résultats.

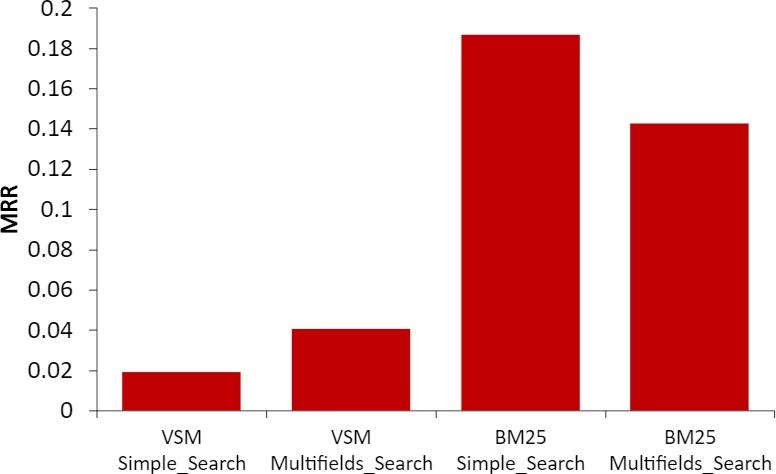

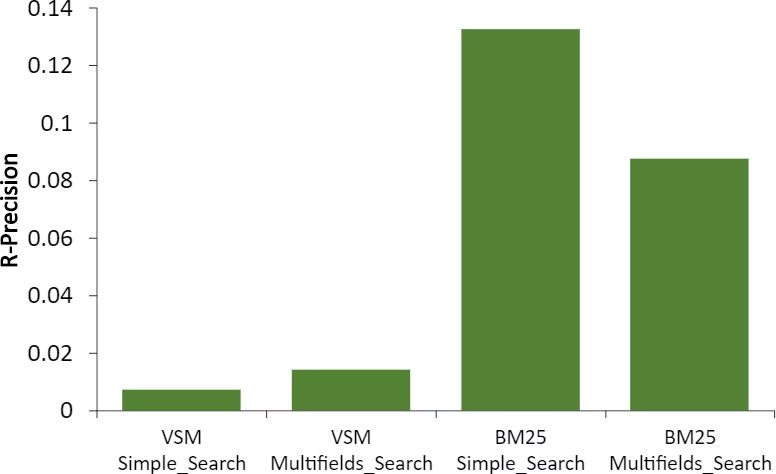

Histogrammes MAP, MRR et R-Précision

Les histogrammes dans la Figure 4.1 représenent le MRR, la MAP et le R Précision de chaque méthode de recherche. Nous remarquons d’abord que toutes les méthodes qui utilisent la métrique BM25 comme métrique de classement des documents surpassent de loin les méthodes VSM en terme de précision moyenne. Cela dit, la métrique BM25 étant plus sophistiquée et étant plus précise, permet une recherche plus performante et plus assurée.

Maintenant, après avoir comparé les deux métriques de classement, nous passons directement à la comparaison des méthodes qui utilisent BM25. Là encore, nous remarquons la supériorité de la méthode de recherche BM25 SimpleSearch.

FIGURE 4.1: Histogrammes d’évaluation du Module de Recherche d’Information.

Une chose de plus à remarquer dans l’histogramme du MRR dans la Figure 4.1, la méthode de recherche BM25 SimpleSearch a un score MRR et MAP égal à 0.20. Ceci dit, cette méthode permet d’avoir en moyenne le bon document parmi les 5 premiers documents retournés, ce qui, d’après notre choix, fournit en général toujours le bon document que nous cherchons parmi les 5 premiers documents envoyés au classifieur.

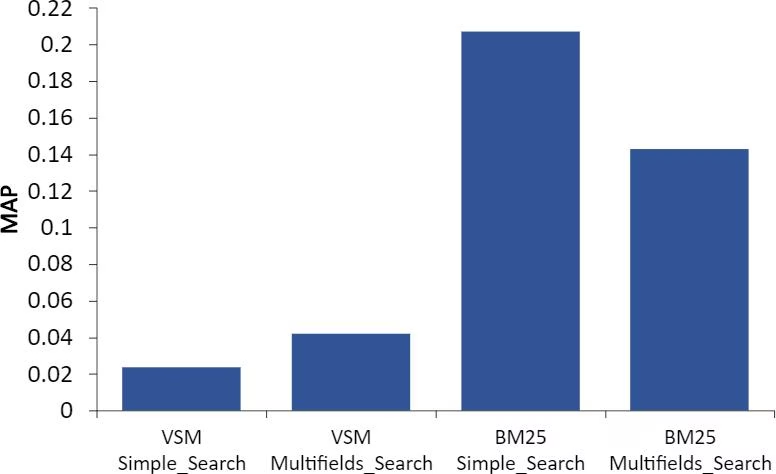

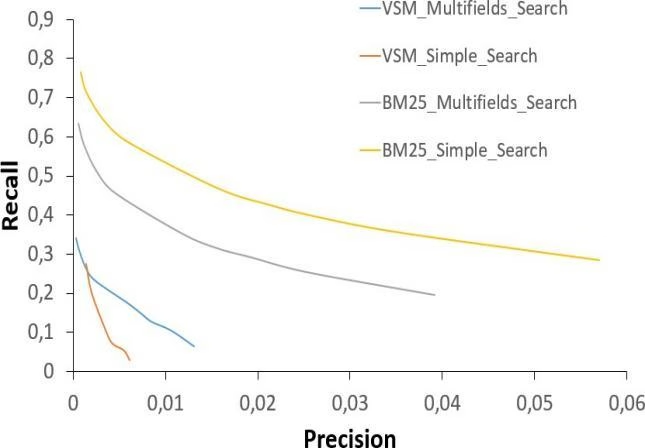

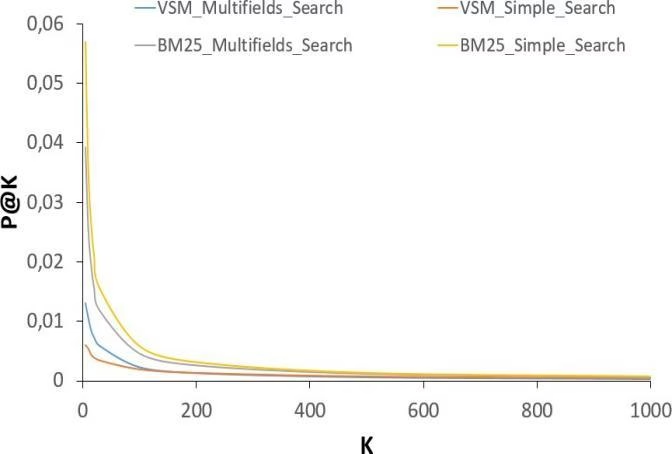

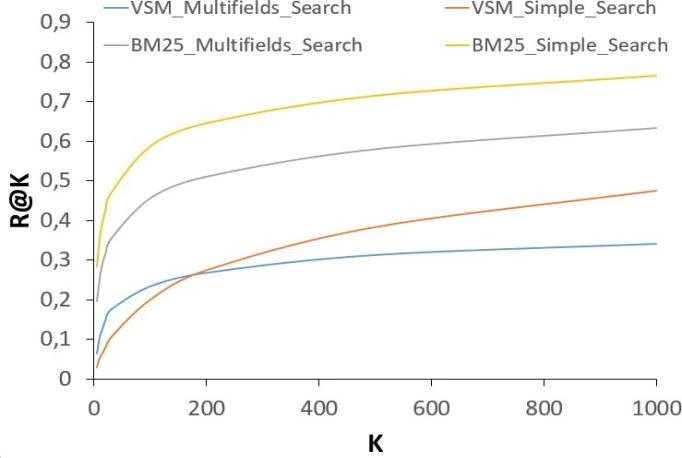

Graphes Précision, Rappel et précision-rappel

Ces autres métriques viennent confirmer ce que nous avons constaté précédemment.

Pour les graphes de la précision@K et rappel@K présentés dans la Figure 4.2, ou` K représente le nombre de résultats retournés suite à une recherche, permettent d’affirmer les performances supérieures réalisées par la méthode BM25 SimpleSearch.

Par ailleurs, nous constatons une baisse considérable de la précision en augmentant le nombre K de résultats retournés. Quant au rappel, il augmente en augmentant le nombre K de résultats retournés. Cela est justifié par la façon dont la précision et le rappel sont calculés. D’après la définition des deux métriques, la précision représente le pourcentage de documents prédits correctement par rapport au nombre de documents erronés retournés.

Le rappel lui, implique le pourcentage des documents corrects qui sont donnés sans se préoccuper du nombre de documents erronés retournés. Afin de remédier à tout ça, nous avons établi un nouveau graphe présent dans la Figure 4.2 qui met en valeur la relation précision-rappel à chaque valeur de K. Encore une fois, la méthode BM25 SimpleSearch Figure comme étant la meilleure méthode de recherche en obtenant un rapport précision-rappel toujours au-dessus des autres méthodes.

FIGURE 4.2: Graphes d’évaluation du Module de Recherche d’Information.

à la fin, après avoir comparé les différentes méthodes de recherche présentées antérieurement, nous sortons avec une conclusion qui permet de passer à l’étape suivante qui est le classifieur des documents tout en lui fournissant 5 documents. Le choix du nombre de documents passés au classifieur vient suite aux performances affichées par la méthode de recherche BM25 SimpleSearch, qui en moyenne, permet d’avoir le bon document parmi les 5 premiers documents retournés par notre moteur de recherche (MRR = 0.20).

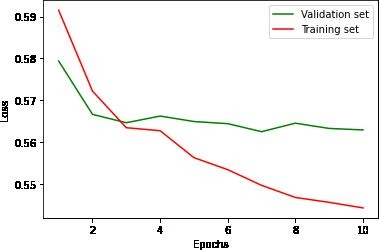

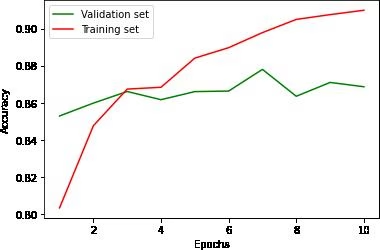

Résultats du module de classification MC

Après la mise en place et obtention des passages pertinents du moteur de recherche, il est nécessaire à présent, de tester le MC et suivre l’évolution du MRR à l’aide d’un ensemble d’expérimentations sur le même dataset « Test Set » utilisé à l’étape précédente, ou` nous vérifions si le système fonctionne, tout en classifiant correctement les réponses acquises. L’évaluation du modèle a été faite sur la base de 2 métriques qui sont : Loss (Erreur) et Accuracy. Ci-dessous les graphes des résultats obtenus.

FIGURE 4.3: Graphes d’évaluation du Module de Classification.

D’après la Figure 4.3, nous remarquons que l’Accuracy augmente avec le nombre d’époques, jusqu’à l’Epoch (10), avec un pourcentage de 92% durant l’apprentissage (Training) et 87% sur le Validation dataset. De même, l’erreur d’apprentissage (Training) et de la Validation varient avec le nombre d’Epochs, ou` le Training Loss diminue jusqu’à l’atteinte de 0.54 à la fin de cette étape et le Validation Loss se stabilise au bout de 10 Epochs, dans la valeur 0.57.

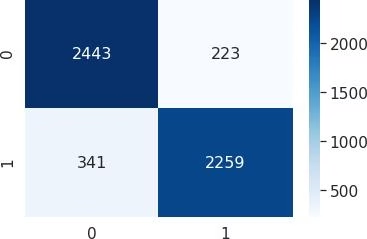

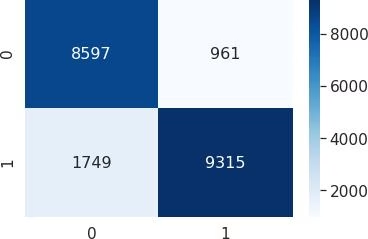

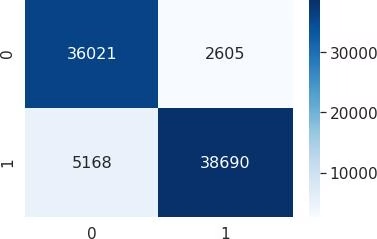

FIGURE 4.3: Matrices de confusion du MC.

D’après la figure 4.3, nous remarquons qu’en fin d’apprentissage, la totalité des réponses mal classées est de 7 773 réponses, un taux d’erreur de 9% et la totalité des réponses bien classées est de 109 964, donc un taux de précision de 93%. Nous notons également que le nombre de réponses mal classées durant la validation est de 1992 réponses ce qui est égal à un taux d’erreur de 13% et le nombre de réponses bien classées est de 109 964, de ce fait, un taux de précision de 95%. Le MC a atteint un taux d’erreur et une précision égales à 11% et 91% resp. sur le Test Set.

Résultats du module d’extraction des réponses MER

Dans cette section, nous allons discuter l’exactitude des résultats du MER. Pour ce faire, nous avons calculé les deux métriques : Loss (Erreur) et Accuracy. Durant l’apprentissage et la validation du modèle, nous avons tracé les courbes pour les deux sous modèles de détection du début et de fin de réponse.

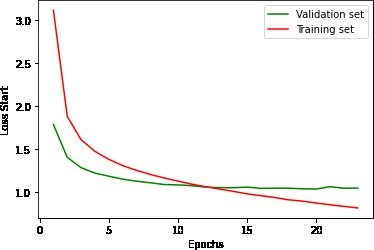

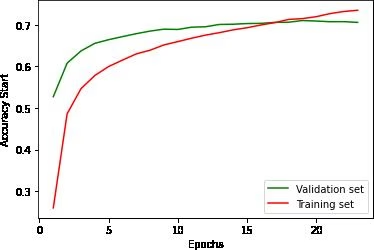

FIGURE 4.4: Graphes d’évaluation du Module d’Extraction de Réponse (Start).

Nous observons sur les graphiques figures 4.4 que la courbe de Training Accuracy pour la détection du début a atteint une valeur de 75% au bout de 14 Epochs, tandis que la Validation Accuracy s’est stabilisée à partir du 9ème Epoch à un pourcentage de 70%. Nous enregistrons en parallèle la diminution du Training Loss de ce modèle jusqu’à la valeur 0.75 au 15ème Epoch et le Validation Loss qui s’est figé à la valeur 1.12 à partir du 8ème Epoch.

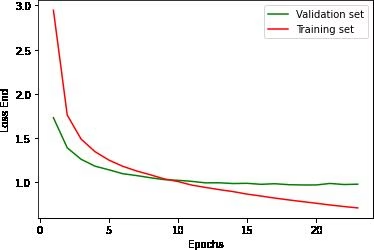

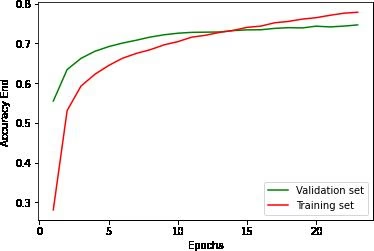

FIGURE 4.5: Graphes d’évaluation du Module d’Extraction de Réponse (End).

Les courbes de Accuracy et Loss du deuxième sous-modèle de détection de fin sont présentées dans la figure

Nous remarquons dans ces dernières que la détection du début sur la Training Accuracy a atteint une valeur de 80% après 14 epochs d’apprentissage. Tandis que la Validation Accuracy a accru jusqu’à 73% au 9ème Epoch. Nous notons également que le Training Loss de ce modèle a diminué jusqu’à la valeur 0.75 au 15ème Epoch et le Validation Loss est 1.12 dès le 8ème Epoch.

Dans le but de tester l’efficacité de notre modèle, nous avons utilisé l’évaluateur proposé par SQUAD 1, qui prend comme entrée un fichier contenant les réponses extraites à partir des contextes de SQUAD pour chaque question du Test Set, et donne en sortie les métriques F1-Score et Exact Match.les résultats enregistrés sont les suivant :

— « exact » : 86.85,

— « f1 » : 91.58,

— « total » : 11873,

— « HasAns total » : 5928.

https://rajpurkar.github.io/SQuAD-explorer/

Les résultats présentés ci-dessus montrent que le Test Set contient 5928 questions ayant une réponse dans leurs contextes d’un total de 11873 questions. Notre MER a pu atteindre un Exact Match de ∼ 87% et un F1-Score de ∼ 92%.

Déploiement et test du système

Les résultats obtenus des questions sans réponses sont liés directement au manque d’informations sur la base de documents Wikipédia car il y a des questions qui sont subjectives comme l’opinion sur un sujet ou plus encore des questions de confirmation (les questions qui ont comme réponses Oui ou Non). De plus, et comme nous avons vu précédemment, chaque module présente une marge d’erreur à son niveau. Cela dit, la partie des résultats erronés obtenus sont dus à ces imperfections.

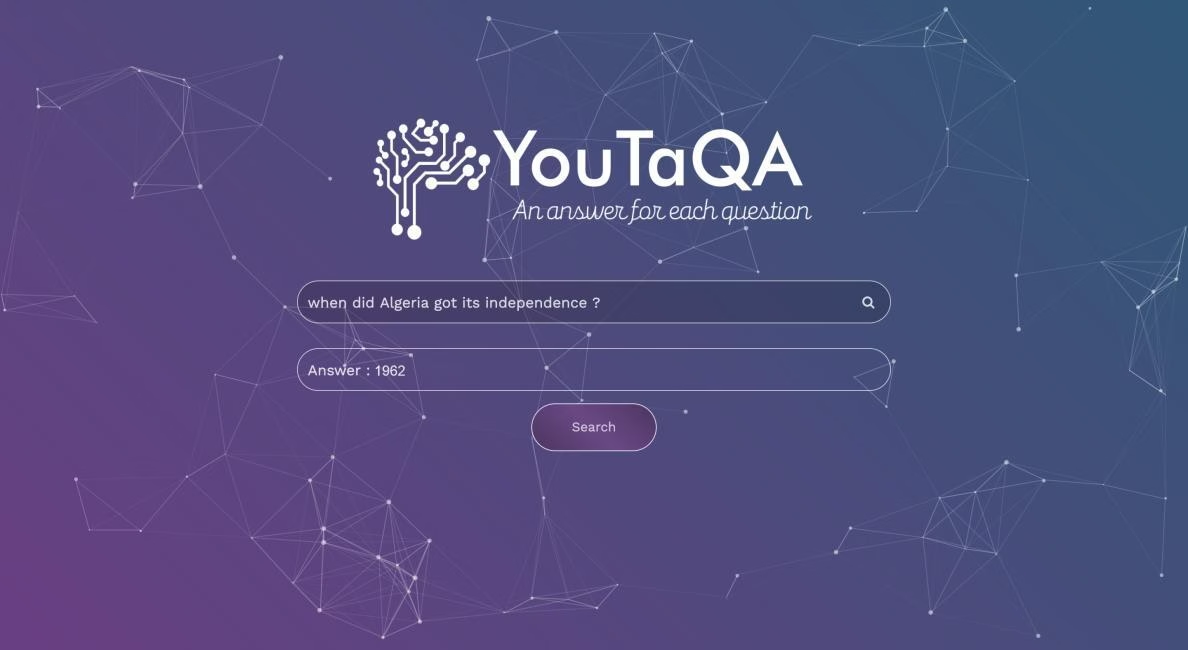

FIGURE 4.6: Exemple d’utilisation du système YouTaQA

Nous estimons que notre système affiche des performances globales acceptables en prenant en compte la marge d’erreur et les limites liées à la source d’information de notre système ainsi qu’un temps d’exécution moyen de 5 ∼ 6 secondes seulement.

Conclusion

Dans ce dernier chapitre, nous avons présenté les résultats donnés par l’implémentation de notre architecture présentée dans le chapitre précédent. Nous avons testé nos modules et avons présenté et discuté les résultats obtenus en calculant des métriques d’évaluation et en présentant des graphes afin de faciliter la comparaison des expérimentations.

Conclusion Générale

Le travail qui nous a été confiés dans le cadre de notre projet de fin d’études, consiste à concevoir et réaliser un système complet de questions-réponses basé sur la recherche d’information.

Le but principal de notre système était de fournir une solution complète qui, après l’identification des problèmes rencontrés dans les travaux précédents, facilitera la réponse aux questions des utilisateurs. La tâche principale des systèmes QAS existants étant de répondre aux questions en exigeant tout de même un passage dans lequel il extrairait la réponse, notre système permettra aux utilisateurs d’automatiser la fourniture du passage en utilisant un moteur de recherche performant et rapide.

Nous nous sommes appuyés sur l’application des méthodes innovantes basées sur le Deep Learning afin de décrire et éliminer avec succès les anomalies et les problèmes que nous avons rencontrés au fil des étapes du développement de la solution.

Pour but de réaliser le pipeline complet de notre système nommé YouTaQA, nous avons tout d’abord implémenté un moteur de recherche en utilisant la base de documents Wikipédia comme source d’informations, tout en considérant chaque section d’article comme étant un document en lui-même afin d’affiner les résultats de recherche. Ensuite, en se basant sur le Deep Learning et spécialement le modèle BERT qui permet d’atteindre l’état de l’art à l’heure ou` cette thèse a été rédigée, nous avons bâti un module de classification de documents qui sert à reclasser les passages résultants de notre moteur de recherche en lui fournissant la question et les 5 meilleurs passages, cela nous permet à chaque fois d’identifier le passage le plus probable et d’avoir une réponse exacte à une question donnée.

é tant notre Classifieur basé sur le Deep Learning, nous avons été amenés à faire un entrâınement à ce dernier, ce qui nous a poussés à choisir le DataSet de SQUAD réalisé par l’université de Stanford et qui fournit plus de 150.000 paires de question-passage et qui précise à chaque paire si le passage contient une réponse à la question. Après l’avoir entrâıné, notre Classifieur permet désormais des performances convergentes vers l’état de l’art actuel en affichant une Accuracy égale à 87% et une Précision de 89% sur le Test Set ce qui est plus qu’acceptable en prenant compte la difficulté des tâches NLP et de la classification du texte en particulier.

Ensuite, et après avoir choisi le meilleur passage susceptible à contenir une réponse à la question posée par l’utilisateur, la tâche la plus importante était d’extraire la réponse exacte à cette question, d’ou` le module d’extraction des réponses MER a été réalisé afin d’accomplir cette tâche. Le module d’extraction des réponses a été implémenté en utilisant le modèle BERT et a été entrâıné en s’appuyant sur le DataSet SQuAD. Le module MER affiche un F1-Score égal à 92% et un Exact Match de 87% en le testant sur plus de 5 000 questions, ce score représente une contribution qui pourrait être ajoutée à la littérature.

Afin de tout concrétiser, et de fournir une expérience utilisateur digne d’un système haut niveau, nous avons implémenté une application web moderne qui satisfait les normes internationales de design.

Perspectives

Les travaux rapportés dans cette thèse ne composent qu’un simple morceau dans un puzzle de travaux supplémentaires qui doivent être réalisés pour aboutir à un système parfait. Pour cela, les perspectives envisageables afin d’améliorer ce travail sont multiples, nous citons :

Améliorer notre moteur de recherche en employant des méthodes basées sur le Deep Learning.

Implémenter un module de mise à jour automatique qui permet d’actualiser la base des documents Wikipédia régulièrement afin d’envisager de répondre aux questions liées aux nouveaux sujets.

Mettre en œuvre la version arabe et française de notre système YouTaQA pour but d’atteindre une plus large communauté.

Implémenter une API afin de faciliter l’utilisation du noyau YouTaQA dans des applications tierces. Pour finir, le savoir est la seule matière qui s’accroisse quand on la partage, comme le dit Socrate, sur ce, nous avons mis à disposition notre code source sur GitHub : https://github.com/rbouadjenek/YouTaQA.